Dify:企业级 LLM 应用落地的理想之选

它不仅内置了构建 LLM 应用所需的关键技术栈,如对数百个模型的支持、直观的 Prompt 编排界面、高质量的 RAG 引擎、稳健的 Agent 框架和灵活的流程编排,还提供了一套易用的界面和 API。同时,Dify 在 RAG 引擎、Prompt 管理、工作流编排等功能上与 LLM 的结合更为紧密,提供了更强大的 LLM 专用能力,而 n8n 作为一个通用的自动化工具,其在 LLM 领域的功能支

(本文有点长,可以先关注一下有空再看)

在当今人工智能快速发展的时代,大型语言模型(LLM)应用的开发和部署成为了企业数字化转型的关键环节。Dify 作为一款开源的 LLM 应用开发平台,凭借其独特的优势和完善的架构,为企业级 LLM 应用的落地提供了优质解决方案,在众多同类工具中脱颖而出。

一、Dify 的定位

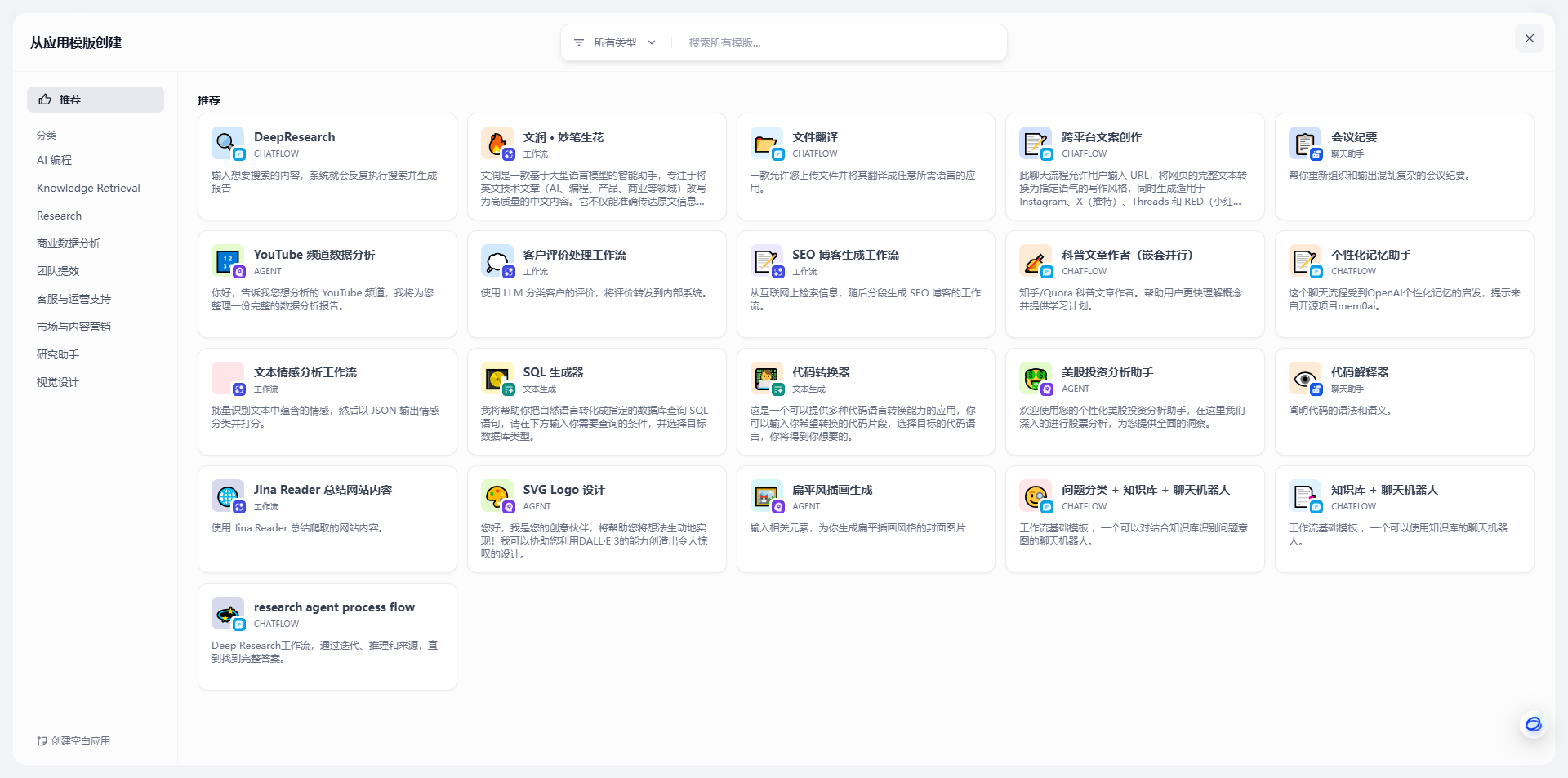

Dify 定位为一款开源的大语言模型(LLM)应用开发平台,融合了后端即服务(Backend as Service)和 LLMOps 的理念。与 LangChain 等开发库不同,Dify 更像是为生产环境量身打造的一套完整脚手架。它不仅内置了构建 LLM 应用所需的关键技术栈,如对数百个模型的支持、直观的 Prompt 编排界面、高质量的 RAG 引擎、稳健的 Agent 框架和灵活的流程编排,还提供了一套易用的界面和 API。这使得开发者能够节省大量重复造轮子的时间,专注于创新和业务需求,即使非技术人员也能参与到 AI 应用的定义和数据运营过程中。

图片

二、Dify 与其他工具的比较

Dify 与 LangChain、Flowise

编程方式

LangChain 以 Python 代码为主,Flowise 更倾向于 App - oriented,而 Dify 采用 API + App - oriented 的方式,这种编程方式使得 Dify 无论是在扩展性还是应用集成方面都更为灵活。

LLMs支持

三者都支持丰富的 LLMs,但 Dify 在企业级应用的支持上更为完善,提供更加全面的模型管理和监控功能。

RAG Engine

LangChain 和 Flowise 都有 RAG Engine 功能,但 Dify 的 RAG 引擎在性能和易用性上更具优势,能够更好地处理大规模知识库和复杂的用户查询。

Agent

LangChain 和 Dify 都支持 Agent,但 Dify 的 Agent 框架更加稳健,能够实现更复杂的任务自动化和决策支持。

Workflow

Dify 和 Flowise 都支持工作流,但 Dify 的视觉工作流构建器更为强大,能够帮助用户更直观地设计和管理复杂的 AI 应用工作流。

Observability

Dify 和 LangChain 都具备可观测性,但 Dify 提供了更深入的监控和分析功能,能够更好地支持企业级应用的性能优化和故障排除。

企业功能

Dify 在企业功能方面具有明显优势,提供了更多针对企业需求的功能,如访问控制、审计日志等。

Dify 与 n8n

功能定位

n8n 是一个通用的自动化工具,主要侧重于工作流自动化和集成,而 Dify 专注于 LLM 应用开发,提供了更为专业的 LLM 功能支持。

易用性

Dify 提供了更直观的界面和更简单的操作方式,使得非技术人员也能够轻松参与到 AI 应用开发中,而 n8n 的使用需要一定的技术背景和开发经验。

集成能力

虽然 n8n 可以通过插件等方式集成各种工具和应用,但在 LLM 领域的集成深度和广度上,Dify 仍然展现出一定的优势。Dify 能够更好地与各种 LLM 提供商进行深度集成,包括对国内大模型的支持,而 n8n 在集成国内大模型时可能需要用户自行补充 API 调用。同时,Dify 在 RAG 引擎、Prompt 管理、工作流编排等功能上与 LLM 的结合更为紧密,提供了更强大的 LLM 专用能力,而 n8n 作为一个通用的自动化工具,其在 LLM 领域的功能支持相对较为通用,可能需要用户进行更多的自定义开发工作来实现特定的 LLM 应用需求。

三、Dify 项目技术路线及前后端架构

技术路线

Dify 采用了一套现代化的技术路线,以满足企业级 LLM 应用开发的高要求。它通过结合视觉工具和 API,提供了一个端到端的解决方案,支持整个 AI 应用开发的生命周期,包括模型集成、Prompt 编排、知识管理、工作流编排和部署等环节。

Dify 的架构设计清晰,前后端分离,具有良好的可扩展性和可维护性。其前端使用 React 框架构建,提供了一个直观的用户界面,包括工作流构建器、Prompt 编辑器、数据集管理等工具,方便开发者进行应用开发和测试。后端采用服务导向型架构,使用 Python 和 Node.js 等主流编程语言构建,提供了 REST API,支持前后端的交互以及与其他系统的集成。

核心组件

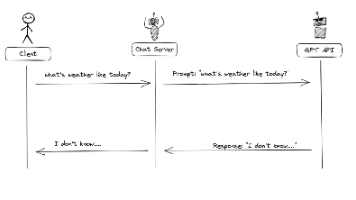

会话系统

负责处理聊天会话和消息管理,支持多种类型的应用运行器,能够与其他组件进行有效协作,实现复杂的对话管理和消息传递功能。

RAG 知识系统

通过文档摄取、分块和嵌入等操作,将文本转化为向量表示,实现知识检索,使得应用程序能够基于文档知识进行回答,提高了知识型应用的准确性和效率。

模型提供商系统

抽象了与各种 LLM 提供商的交互,提供统一的接口,支持 LLM 文本生成、文本嵌入、语音能力等功能,方便开发者在不同模型之间进行切换和集成,提高了应用的灵活性和可扩展性。

工作流系统

支持视觉创建工作流,能够将不同的组件连接成一个完整的应用,实现了复杂 AI 应用流程的编排和执行,提高了应用的开发效率和可维护性。

部署选项

Dify 提供了多种部署选项,包括 Dify Cloud、自托管社区版和企业版。Dify Cloud 是托管服务,无需设置,方便用户快速上手;自托管社区版基于 Docker 部署,适合对数据隐私和控制有较高要求的企业;企业版则提供了增强功能,满足组织的特定需求。这种多样化的部署方式为企业提供了更灵活的选择,能够根据自身实际情况进行选择。

四、后端即服务(Backend as Service)的优势

Dify 采用后端即服务(Backend as Service)模式,为企业级 LLM 应用开发带来了诸多优势。

减少开发工作量

开发者无需从头开始构建后端系统,可以直接使用 Dify 提供的现成功能和 API,大大减少了开发工作量和时间成本,能够更快地将应用推向市场。

提高开发效率

BaaS 模式使得开发者可以专注于前端界面和业务逻辑的实现,后端的维护和更新由 Dify 团队负责,提高了开发效率和应用的稳定性。

易于扩展和集成

Dify 的后端系统提供了丰富的 API 和插件支持,方便与其他系统进行集成和扩展,能够更好地满足企业复杂多变的业务需求。

数据安全与隐私保护

对于数据安全和隐私有严格要求的企业,Dify 的自托管部署方式允许企业对数据进行完全控制,确保数据的安全性和合规性。

五、Dify 的局限性

尽管 Dify 具备诸多优势,但在实际应用中也存在一些局限性,主要体现在以下几个方面:

学习成本

虽然 Dify 提供了直观的界面和丰富的功能,但要熟练掌握其复杂的视觉工作流构建器和各种高级功能(如 RAG 引擎配置、Agent 框架定制等),用户仍需投入一定时间进行学习。对于完全没有技术背景的用户来说,可能会面临一定的学习曲线挑战。

系统集成度

在与某些特定企业系统或遗留系统的集成方面,Dify 可能无法达到完美。例如,与企业内部的特定行业应用软件集成时,可能需要额外的开发工作来实现无缝对接。此外,Dify 的 API 在某些复杂的集成场景下可能需要进一步优化以提高数据传输效率和稳定性。

模型优化能力

Dify 虽然支持多种 LLMs,但在模型的深度优化方面,例如针对特定领域的模型微调(Fine - tuning)和性能优化(如推理速度提升、内存使用优化等),其提供的工具和方法相对较有限。企业需要自行投入资源进行模型优化,或依赖外部专家团队来满足特定业务场景下对模型性能的高要求。

社区支持和功能完整性

作为一个开源项目,Dify 的社区活跃度和贡献度对平台的持续发展和功能完善至关重要。目前,与一些成熟的开源项目相比,Dify 的社区规模相对较小,部分功能的文档和示例可能不够丰富。这可能导致用户在遇到问题时无法快速找到解决方案,影响开发进度。同时,Dify 的功能完整性在某些特定领域(如高级语音处理)仍有待提高,无法完全满足所有企业的多样化需求。

Dify 凭借其精准的定位、强大的功能、灵活的技术架构以及后端即服务的优势,成为企业级 LLM 应用落地的理想之选。企业在采用 Dify 时,应根据自身实际情况权衡利弊,充分发挥其优势,同时积极应对这些局限性,通过不断学习和探索,推动企业数字化转型和创新发展进程。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)