新手必知:ExGRPO 框架的核心组件与工作流程

通过上述组件和流程,ExGRPO 能够在复杂环境中实现高效策略优化,适用于连续控制、多智能体协作等场景。负责生成动作概率分布,通常基于深度神经网络(DNN),输入为环境状态,输出为动作或动作概率。评估当前状态或动作的长期回报,分为状态价值函数(V(s))和动作价值函数(Q(s, a))。定期同步目标网络参数(若采用双网络结构),并评估当前策略的性能,调整超参数或探索率。智能体在环境中执行动作,观测

ExGRPO 框架的核心组件

ExGRPO(Extended Generalized Reinforcement Policy Optimization)是一种扩展的强化学习框架,主要用于策略优化和决策建模。其核心组件包括:

策略网络(Policy Network)

负责生成动作概率分布,通常基于深度神经网络(DNN),输入为环境状态,输出为动作或动作概率。

价值函数(Value Function)

评估当前状态或动作的长期回报,分为状态价值函数(V(s))和动作价值函数(Q(s, a))。

广义优势估计(GAE)

用于减少策略梯度估计的方差,平衡偏差与方差的关系,公式为:

[ A_t^{GAE} = \sum_{l=0}^{T-t} (\lambda \gamma)^l \delta_{t+l} ]

其中 (\delta_t = r_t + \gamma V(s_{t+1}) - V(s_t))。

经验回放缓冲区(Replay Buffer)

存储历史状态、动作、奖励等数据,支持离线学习或混合学习模式。

优化器(Optimizer)

通常采用Adam或RMSProp等自适应优化算法,用于更新策略网络和价值函数参数。

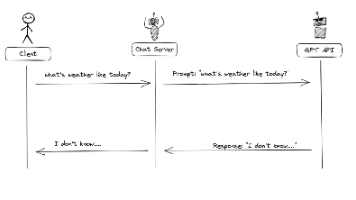

ExGRPO 的工作流程

环境交互与数据收集

智能体在环境中执行动作,观测状态和奖励,并将交互数据存入经验回放缓冲区。

广义优势计算

从缓冲区采样轨迹数据,利用GAE计算优势估计值,用于后续策略梯度更新。

策略梯度更新

通过最大化目标函数 (J(\theta)) 更新策略网络参数,公式为:

[ \nabla_\theta J(\theta) = \mathbb{E} \left[ \nabla_\theta \log \pi_\theta(a|s) A^{GAE}_t \right] ]

价值函数拟合

最小化时序差分误差(TD Error)更新价值函数参数,确保回报估计的准确性。

周期性同步与评估

定期同步目标网络参数(若采用双网络结构),并评估当前策略的性能,调整超参数或探索率。

关键实现技巧

参数共享

策略网络与价值函数可共享部分网络层,减少计算资源占用并提升训练效率。

熵正则化

在目标函数中加入策略熵项,鼓励探索,避免过早收敛至局部最优:

[ J(\theta) = \mathbb{E} \left[ A^{GAE}t \log \pi\theta(a|s) + \beta H(\pi_\theta) \right] ]

梯度裁剪

限制策略梯度更新的幅度,防止参数剧烈波动导致训练不稳定。

通过上述组件和流程,ExGRPO 能够在复杂环境中实现高效策略优化,适用于连续控制、多智能体协作等场景。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)