LLM 与 RAG:AI 语言技术的核心搭档

本文介绍了AI语言技术的两大核心技术支柱——LLM(大语言模型)和RAG(检索增强生成)。LLM通过海量数据训练掌握语言能力,擅长自然语言生成但存在知识时效性不足等问题;RAG则通过检索外部知识库增强回答准确性,弥补LLM的不足。两者不是替代关系,而是互补协作:LLM提供核心生成能力,RAG确保事实准确性和知识更新。这种"LLM+RAG"的组合已成为当前AI应用的主流方案,既保

如今,我们日常使用的 ChatGPT、豆包等 AI 工具早已融入生活,但你是否好奇它们背后的核心技术?其实,这些工具的能力主要依赖两大支柱 ——LLM(大语言模型)与 RAG(检索增强生成)。今天,我们就从基础概念到实际应用,全方位拆解这两项技术,以及它们如何协同成为 AI 语言能力的 “黄金组合”。

一、基础篇:什么是 LLM(大语言模型)?

LLM 的全称是Large Language Model,简单来说,它是一种 “能听懂、会说话” 的 AI 模型 —— 通过学习海量文本数据,掌握人类语言的语法、逻辑和知识,最终生成符合人类表达习惯的自然语言内容。

1. LLM 的核心原理:从 “数据” 到 “能力”

LLM 的能力并非凭空而来,而是源于 “海量数据 + 高效架构” 的双重支撑:

-

训练数据:覆盖书籍、网页、论文、新闻等公开文本(需遵守版权),例如早期模型可能学习了数百万本书、数十亿网页,以此沉淀常识与领域知识。

-

核心架构:基于Transformer 框架,核心是 “自注意力机制”—— 处理文本时能同时关注不同词语的关联(比如 “小明” 和 “他” 的指代关系),而非逐字机械处理,这让模型能真正理解上下文逻辑。

-

训练目标:本质是 “预测下一个词”。给定前文(如 “今天天气很好,我打算去”),模型通过学习数据规律,预测最可能的下一个词(如 “公园”“散步”),反复训练后便掌握了语言逻辑。

2. LLM 的关键特点:为什么它 “好用”?

-

强上下文理解:能处理数万字长文本,记住对话或文档中的前后信息。比如你说 “我喜欢爬山”,后续问 “哪里适合新手?”,模型能关联前提推荐路线。

-

自然语言生成:输出流畅度接近人类,可写文案、诗歌、代码注释,甚至模拟对话,避免 “机器人语气”。

-

泛化能力突出:无需单独训练就能处理多任务。比如一个预训练 LLM,不用专门优化 “翻译功能”,只需提示 “把这段文字译成英文”,就能完成翻译。

-

内置海量知识:从训练数据中沉淀了数学、历史、医学等基础常识,但有 “知识截止时间”(如 2023 年训练的模型无法知晓 2024 年新事件)。

-

参数规模庞大:主流模型参数从数十亿到万亿级(如 GPT-3 有 1750 亿参数),参数越多,捕捉的语言细节越丰富,但训练成本也越高。

3. LLM 的典型应用:渗透生活与工作

-

对话交互:客服机器人(解答售后问题)、智能助手(语音答疑、设置日程);

-

内容生成:广告文案、论文草稿、小说片段、歌词创作;

-

信息处理:长报告总结、合同关键条款提取、多语言实时翻译;

-

代码辅助:生成 Python 爬虫、代码纠错、添加解释注释;

-

垂直领域:医疗(整理病历、解释报告)、法律(检索条文、起草合同)、教育(个性化答疑)。

4. LLM 的局限:它不是 “全知全能”

尽管强大,LLM 仍有明显短板,这也为 RAG 的出现埋下伏笔:

-

知识时效性不足:训练数据有截止日期,无法主动获取实时信息(如不知道 2024 年新政策);

-

“幻觉” 问题:可能生成看似合理却虚假的内容(如编造不存在的论文、数据);

-

复杂推理薄弱:处理多步骤数学题、逻辑题易出错(如简单加减正确,代数题可能算错);

-

数据偏见:若训练数据含性别、地域刻板印象,模型会继承这些偏见。

二、进阶篇:什么是 RAG(检索增强生成)?

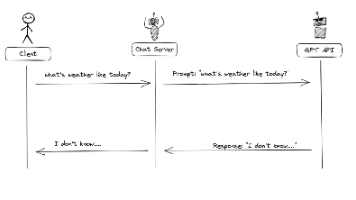

面对 LLM 的局限,RAG(Retrieval-Augmented Generation,检索增强生成) 应运而生。它的核心思路是:给 LLM 配一个 “外挂知识库”,让模型生成回答前先从外部检索真实信息,再基于这些信息输出内容。

1. RAG 的核心价值:解决 LLM 的 “痛点”

RAG 的存在就是为了弥补 LLM 的不足,具体能实现三大突破:

-

增强事实准确性:用检索到的真实数据作为回答依据,减少 “幻觉”;

-

扩展知识边界:引入企业文档、行业报告、实时数据等外部知识,突破 LLM 的知识局限;

-

适配垂直场景:可定制领域知识库(如医疗病历、法律案例),让回答更专业。

2. RAG 的典型应用场景

-

智能问答:企业内部文档问答(员工查规章制度)、客服机器人(用户问产品保修);

-

知识库助手:管理论文、病历等非结构化数据,用户提问时定位具体段落并总结;

-

内容生成辅助:写报告时检索相关文献、数据,让内容有明确来源(如 “根据 2024 年行业报告,增长率为 X%”);

-

实时信息整合:结合新闻、股价等实时接口,回答 “今天某公司公告内容” 这类时效性问题。

3. RAG 的核心流程:分 “离线准备” 与 “在线交互”

RAG 的实现需两步走,确保 “检索准、生成稳”:

(1)离线准备:构建可检索的知识库

-

数据处理:收集知识源(文档、PDF、网页等),清洗(去重、纠错)后拆分成长度合适的片段(如段落级,方便检索);

-

构建向量数据库:用 “嵌入模型”(如 Sentence-BERT、OpenAI Embedding)将文本片段转换成 “向量”(数字表示),存储到向量数据库(如 Milvus、Pinecone、Chroma)—— 向量的作用是通过 “语义相似度” 快速找相关内容。

(2)在线交互:用户提问到生成回答的全流程

以 “某产品保修期多久?” 为例:

-

接收查询:获取用户问题;

-

检索知识:用嵌入模型将问题转成向量,在向量数据库中找到最相似的文本片段(如产品手册中关于保修的段落);

-

生成回答:将检索到的片段作为 “上下文”,和问题一起输入 LLM,让模型基于事实生成回答(避免编造)。

4. RAG 的关键优化点

-

提升检索精度:调整文本拆分方式(按语义而非固定长度)、优化嵌入模型,确保检索内容与问题强相关;

-

优化提示词:设计清晰提示(如 “仅基于以下信息回答,不编造内容”),让 LLM 更高效利用上下文;

-

更新知识库:定期同步新数据到向量数据库,保证知识时效性。

三、协同篇:LLM 与 RAG 的关系 —— 不是替代,而是互补

很多人会问:LLM 和 RAG 是竞争关系吗?答案是否定的 —— 它们是深度协作的搭档,LLM 是 “核心生成引擎”,RAG 是 “增强工具”,二者结合才能发挥最大价值。

1. 一句话讲清关系:RAG 依赖 LLM,LLM 需要 RAG

-

RAG 无法脱离 LLM 独立存在:RAG 的最终目标是 “生成回答”,而生成能力完全依赖 LLM—— 检索到的碎片化信息,需 LLM 整合、转化为自然语言,否则 RAG 只能像传统搜索引擎一样返回链接,无法直接回答。

-

LLM 需要 RAG 补短板:LLM 的知识过时、幻觉、领域知识不足等问题,只有通过 RAG 的 “外部检索” 才能解决 —— 相当于给 LLM 配了 “实时参考书”,让它说话时有据可依。

2. 二者协作实例:以 “某公司 2024 年净利润” 为例

-

用户提问:“某公司 2024 年净利润是多少?”;

-

RAG 行动:检索外部知识库中该公司 2024 年财报片段(如 “净利润 5.2 亿元,同比增长 12%”);

-

LLM 行动:将财报片段作为上下文,输入模型,生成回答:“根据该公司 2024 年财报,其净利润为 5.2 亿元,较去年增长 12%”。

3. 定位差异:基础模型 vs 场景方案

-

LLM 是 “通用基础模型”:具备通用语言能力,可独立用于不需要精准事实的场景(如写诗歌、简单聊天);

-

RAG 是 “场景化应用方案”:专为 “事实准确、知识可控” 的场景设计(如企业客服、医疗咨询),必须结合 LLM 才能落地。

四、总结:LLM+RAG——AI 语言技术的落地主流

LLM 是 “能说会道的大脑”,但自带 “记忆不全、偶尔瞎编” 的缺点;RAG 是 “实时参考书”,让大脑说话时有据可依、信息更新。二者结合,既保留了 LLM 的生成能力,又解决了实际场景中的可靠性问题 —— 这也是当前企业落地 AI 时,“LLM+RAG” 成为主流方案的核心原因。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)