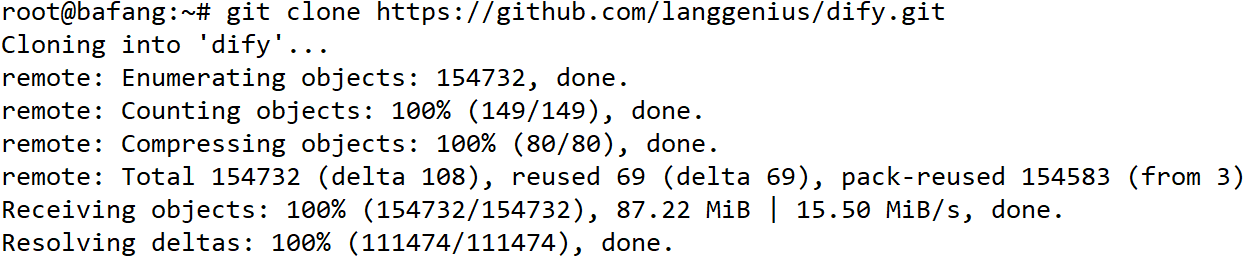

Ubuntu虚拟机部署Dify+Ollama搭建智能体和工作流

Dify是一个开源的生成式AI应用开发平台,支持低代码开发、多模型切换和RAG技术。用户可快速构建智能客服、内容生成等应用。部署时需准备Ubuntu+Docker环境(2核CPU/4GB内存以上),下载Dify源码后通过docker-compose启动。安装后需配置Ollama模型供应商并下载大语言模型(如千问7B)。平台支持调整上传文件大小限制(默认15MB),修改后需重启容器。虚拟机部署需注意

注意:实测虚拟机中的Ollama响应效率比较低,推荐使用Dify、Coze等在线工作流平台

Dify介绍

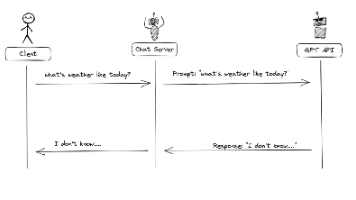

Dify 是一个开源的生成式人工智能(GenAI)应用开发平台,旨在帮助开发者快速构建、部署和管理基于大语言模型(LLM)的应用。

它结合了后端即服务(Backend-as-a-Service,BaaS)和 LLM 运营(LLMOps)的理念,提供了从创建智能体到复杂 AI 工作流的全面解决方案。

核心功能

- 低代码/无代码开发:Dify 提供直观的可视化界面,允许用户通过拖放操作快速构建 AI 应用,无需深厚的编程知识。

- 多模态与多模型支持:支持多种流行的 LLM(如 OpenAI 的 GPT 系列、Anthropic、Google Gemini 等),并能够灵活切换。

- RAG 引擎:通过检索增强生成(Retrieval-Augmented Generation,RAG)技术,将私有数据与 LLM 安全连接,支持多种索引和检索方法。

- 工作流编排:用户可以定义和管理 AI 工作流,确保输出的稳定性和可控性。

- 插件系统:Dify 的插件系统和 Marketplace 允许开发者通过定制组件和工具扩展应用功能。

应用场景

- 智能客服与聊天机器人:快速部署定制化的聊天机器人或 AI 助手,嵌入领域知识,提升客户服务体验。

- 内容生成:生成清晰、逻辑性强的文档,支持无长度限制的文档生成和长文档总结。

- 企业知识库与智能搜索:利用企业内部知识库,提供智能搜索和问答服务。

- 自动化流程:通过 AI 代理(Agent)技术,实现复杂任务的自动化处理。

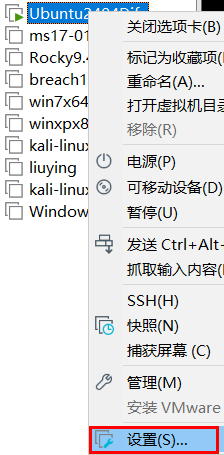

操作系统准备

首先准备一台安装好了Docker的Ubuntu机器(推荐使用免安装版24.04)

配置要求:

CPU >= 2 Core

RAM >= 4 GiB把虚拟机内存调大一些:

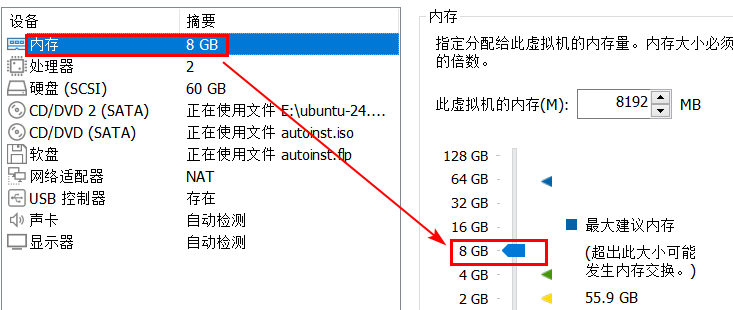

检查基础环境

检查Docker和Git是否正确安装:

注意:docker-compose的版本要大于2.24

docker -v

docker-compose -v

git --version启动docker

systemctl start docker

停止其他HTTP 80、HTTPS 443端口

避免Dify启动时端口冲突

lsof -i :80

lsof -i :443如果80端口已启动:

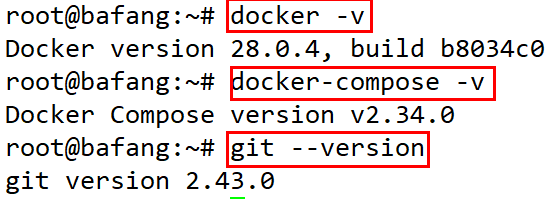

systemctl stop apache2下载Dify源代码

(如果连接github有问题,可以用windows下载以后传输到虚拟机)

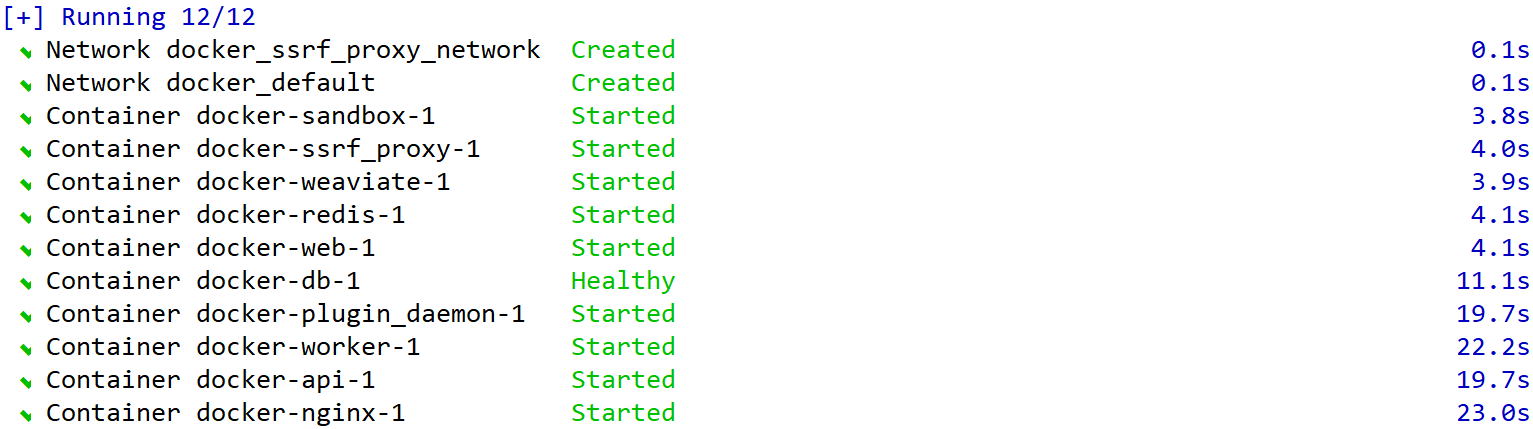

启动Dify

cd dify

cd docker

cp .env.example .env

docker compose up -d

登录UI界面

在浏览器中输入虚拟机的IP地址,例如:

http://192.168.142.152此时会自动跳转到install

http://192.168.142.152/install输入邮箱、用户名、密码:

设置成功以后使用邮箱、密码登录。

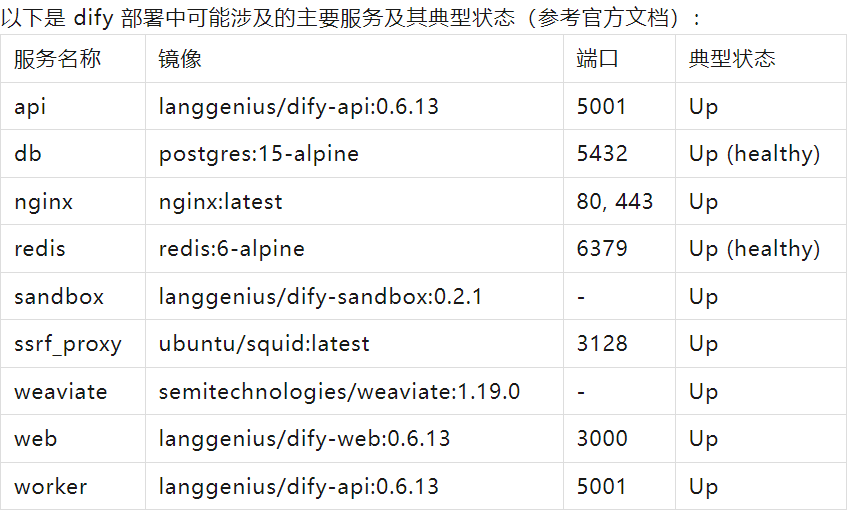

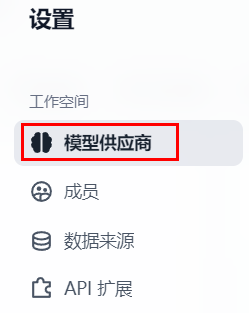

设置模型供应商

打开:http://192.168.142.152

右上角点头像,打开设置

点击:模型供应商

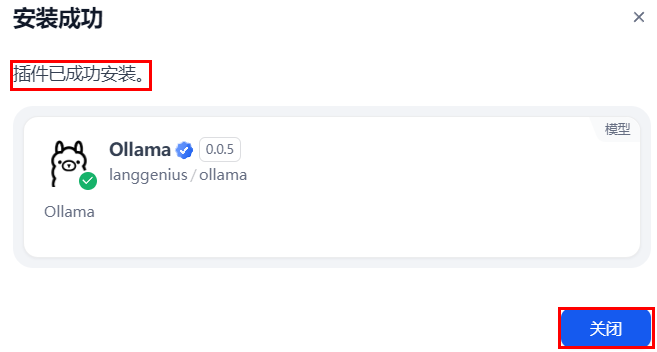

往下翻找到ollama,点安装:

安装成功

(没有安装GPU驱动的情况下,默认使用CPU运行)

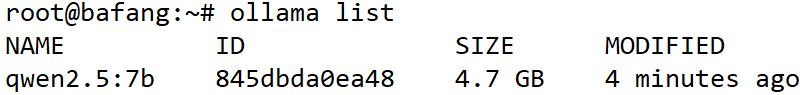

下载千问模型

打开终端(或者Xshell),输入命令:

(大小4.7G,时间视网速情况而定)

ollama run qwen2.5:7b

检查模型下载结果:

ollama list

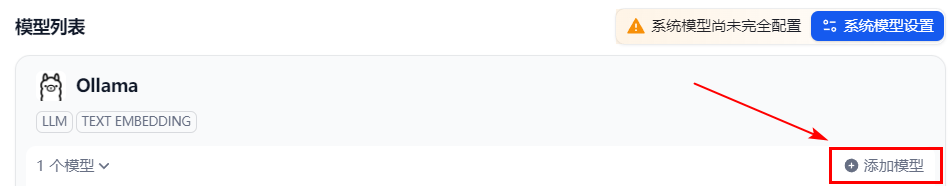

添加模型供应商

http://192.168.142.152/plugins

点击添加模型

输入虚拟机的IP地址,11434端口是固定的,不要改。

其他设置修改:

Dify默认上传文件限制大小15MB,可以在.env里面进行修改配置

UPLOAD_FILE_SIZE_LIMIT,设置单个文件大小限制,例如改为 1500M

NGINX_CLIENT_MAX_BODY_SIZE也要设置一下,改成 1500M

docker-compose.yaml里面也同步更改配置完成以后,需要重启Dify一系列容器。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)